Inhaltsverzeichnis

- Large Language Models und die Frage nach dem Kontext

- Wissensdaten: Das Element, das die KI mighty macht

- Fazit: Chancen des KI-Finetunings

Textschaffende, die in ihrem Arbeitsalltag mit ChatGPT, Claude und Co. arbeiten, kennen womöglich diese Situation: Das Tool soll die Corporate Language des Unternehmens umsetzen, die Struktur von Pressemitteilungen, Postingtexten und Blogbeiträgen beherrschen, eine Persona abbilden, bei der Analyse behilflich sein oder als Sparringspartner:in einspringen, wenn der eigene Kopf leer ist. Wer hier im Sinne des Learning by Doings vorgeht und auf dem sprichwörtlichen weißen Blatt Papier einfach loslegt, ist ggf. schnell frustriert: Die Sprache wird nicht wie erhofft umgesetzt, der Output entspricht nicht dem gewünschten Ergebnis oder die KI nimmt alles viel zu wörtlich. Doch was muss ich tun, um die KI nach meinen Wünschen anzupassen? Wir wagen einen Kopfsprung ins KI-Finetuning!

Was ist KI-Finetuning?

KI-Finetuning ist die Optimierung einer vortrainierten KI, bei der Ziele und Funktionen festgelegt sowie unter anderem Wissensdaten integriert werden, um die Ergebnisse im Output so gut wie möglich zu machen.

Large Language Models und die Frage nach dem Kontext

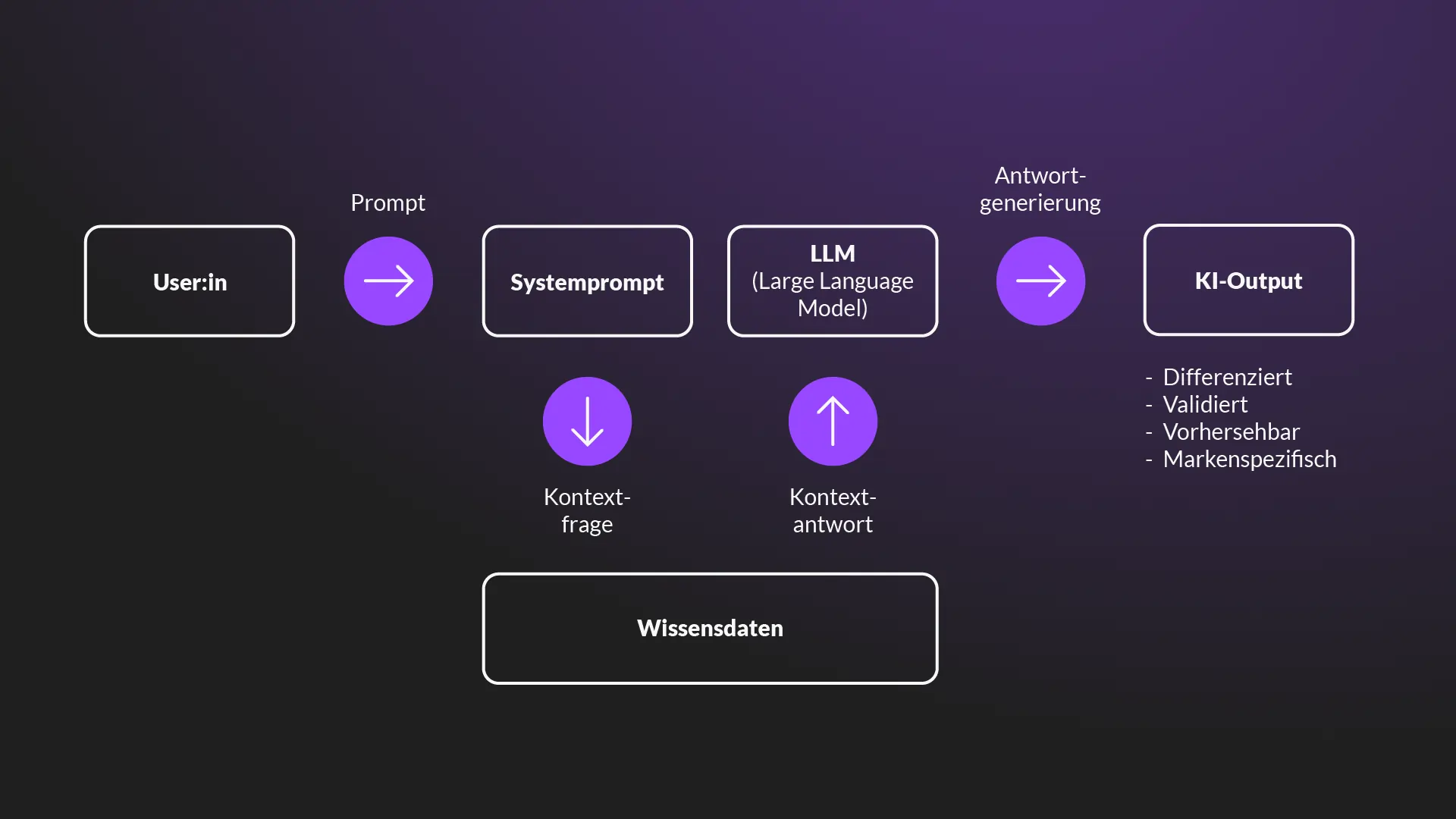

KI-Tools wie ChatGPT, Claude, Mistral oder Llama sind Large Language Models (LLM), die auf den Prinzipien des maschinellen Lernens aufgebaut sind und mit den User:innen menschenähnlich kommunizieren. Indem wir im Chatfenster in Form eines Prompts Fragen formulieren, Anweisungen geben oder andere Forderungen stellen und daraufhin von der KI eine Antwort erhalten, entsteht schnell das Gefühl, dass wir mit einem anderen Menschen sprechen.

Was den Umgang mit der KI dadurch niedrigschwellig macht, wird in der Arbeit aber schnell zum Problem: Während Menschen Zusammenhänge zwischen unterschiedlichen Sachverhalten aufgrund ihres Wissens, ihrer Erfahrungen und empathischen Fähigkeiten direkt erschließen können, hat man es bei einer KI mit einem Programm zu tun, das diese Lücken nicht von allein füllen kann. Dabei ist es völlig egal, ob wir unseren Prompt im Chatfenster formulieren oder die Anweisung als Systemprompt im Hintergrund definieren.

„Prompten ist eigentlich das Formulieren eines guten Briefings.“

Mona Badke, Text, Konzept, Redaktion

Einen Prompt an die KI müssen sich User:innen im Grunde wie ein Briefing vorstellen: Wenn es fehlt, kann die KI nicht arbeiten. Wenn es ungenau oder widersprüchlich ist, weiß sie nicht, was sie tun soll. Hier unterscheidet sich das Tool nicht von uns Menschen, denn auch Textschaffende, Designer:innen, Projektmanager:innen und Co. können nur dann richtig gut arbeiten, wenn der Arbeitsauftrag klar formuliert ist und das Ziel feststeht. Im Endeffekt gelten also beim Formulieren des Systemprompts und der User:innenprompts nicht die geflügelten Worte „Content is King“, sondern „Kontext is King!“.

Eine Anweisung für das Tool zu formulieren, in dem alle wichtigen Informationen hinterlegt sind, ist nicht nur eine Trainingseinheit für die KI, sondern auch für alle User:innen selbst, denn: Wer das Formulieren von Prompts an die KI und mit der KI übt, übt eigentlich das Formulieren guter Briefings.

Was ist ein Systemprompt?

Das ist eine Anforderung, die in Form von Input und Anweisungen an die KI übermittelt wird. Anders als der User:innenprompt, der während des Gesprächs direkt im Chatfenster formuliert wird, läuft der Systemprompt im Hintergrund mit und wird von der KI primär umgesetzt.

Wissensdaten: Das Element, das die KI mighty macht

Kontext ist King, aber Wissen ist Macht! Genauso wie für uns sind auch für die KI Wissensdaten wichtig, um Lücken direkt ausfüllen und Zusammenhänge herstellen zu können. Anders als Menschen, die aufgrund ihrer Lebens- und Arbeitserfahrung automatisch Wissen ansammeln und nutzen können, müssen diese Daten der KI aktiv mitgegeben werden, damit sie damit arbeiten kann.

Diese Wissensdaten müssen für die KI aufbereitet und auch bewertet werden. Nicht alle Daten kann man – Stichwort Datenschutz – einfach so in das System einpflegen. Außerdem gilt es zu unterscheiden, welches Wissen für die Aufgabe direkt relevant ist und welche Hintergrundinformationen die reine Funktion haben, der KI den nötigen Kontext zu vermitteln. Nur wer all diese Dinge gut ausgearbeitet und in Einklang miteinander gebracht hat, kann sich am Ende über einen gut formulierten Output freuen.

Im Prozess des KI-Finetunings endet die Arbeit damit aber nicht. Während Wissensdaten unter Umständen aktualisiert werden müssen, kann es genauso gut vorkommen, dass sich Anforderungen und Arbeitsanweisungen ändern – und damit gleichzeitig auch die Prompts, die ausformuliert wurden. Wer also die eigens trainierte KI immer weiter optimiert, befindet sich mitten im Prozess des Prompt-Engineerings.

Was ist Prompt-Engineering?

Beim Prompt-Engineering entwickeln User:innen sowohl den Systemprompt im Hintergrund als auch die von ihnen selbst eingetippten Prompts und Wissensdaten an die KI ständig weiter. Hier geht es darum, die Anweisungen immer weiter zu optimieren und aktuell zu halten, um die wichtigsten Informationen so kurz, klar und präzise wie möglich an das Tool zu übermitteln.

Fazit: Chancen des KI-Finetunings

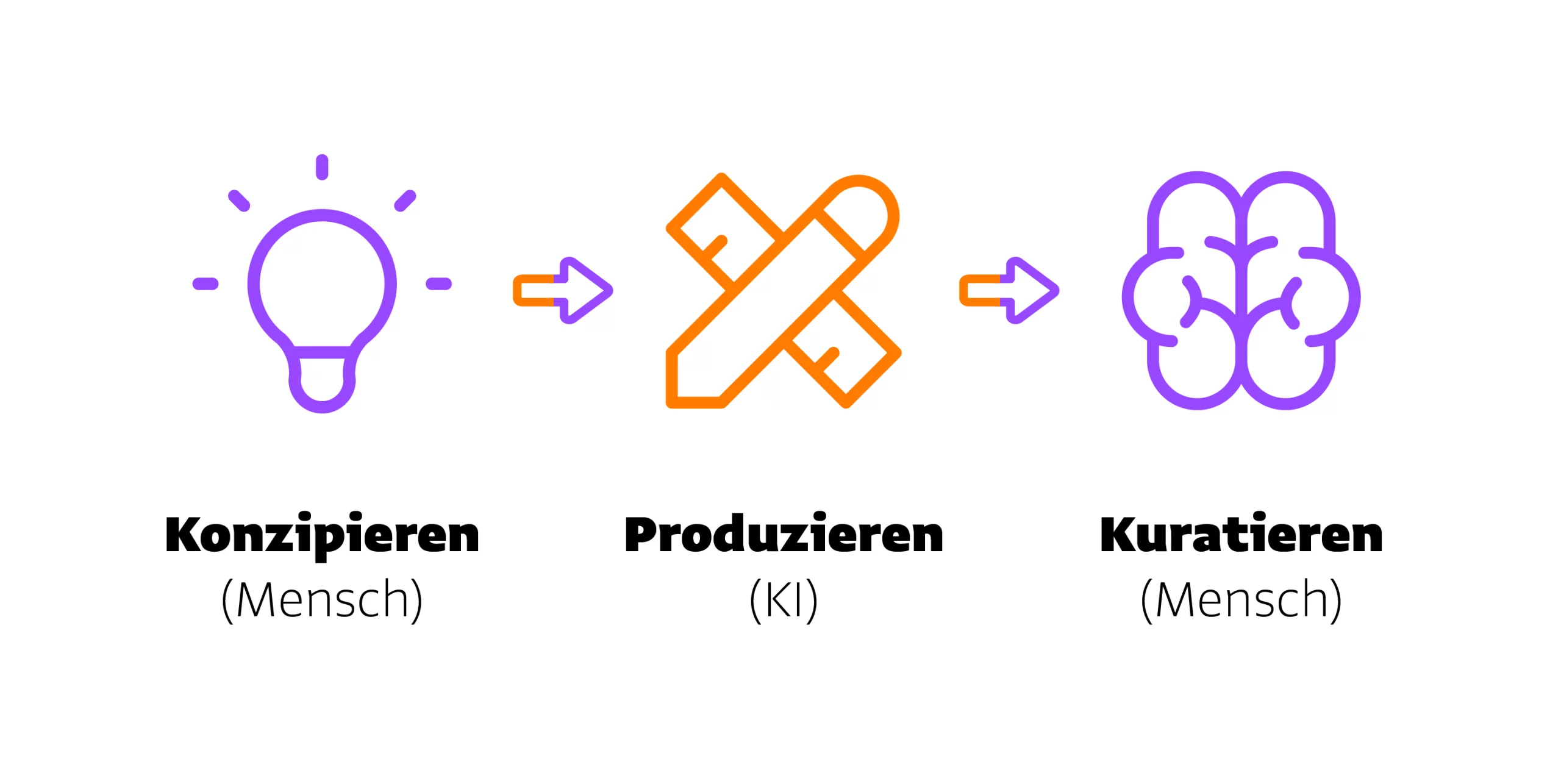

Konzipieren, Generieren, Kuratieren: LLMs können zwar von sich aus schon eine ganze Menge, aber wirklich gut wird das Ergebnis erst, wenn die User:innen ein wenig mehr Zeit investieren. Mit der Aufbereitung von Wissensdaten, einer klaren Zielsetzung und Prompt-Engineering hat man sehr gute Chancen, dass im Output am Ende das Ergebnis herauskommt, das wirklich den Vorstellungen der User:innen entspricht.

Doch wir sind überzeugt, dass das Ende der Fahnenstange noch nicht erreicht ist. Mit unseren Erfahrungen, Learnings und Beobachtungen kratzen wir sicherlich nur an der Spitze des Eisbergs. Was unter der Wasseroberfläche liegt? Lasst es uns herausfinden!

Mit Corporate Language Marken transportieren

Ein einheitlicher Sprachstil wirkt sich auf die Außenwirkung einer Marke aus und schafft Wiedererkennungswert sowie ein kohärentes Markenerlebnis für Kund:innen. Was alles zur Corporate Language dazugehört, erfahrt ihr in unserem Expert:innenbeitrag!